1. 摘要

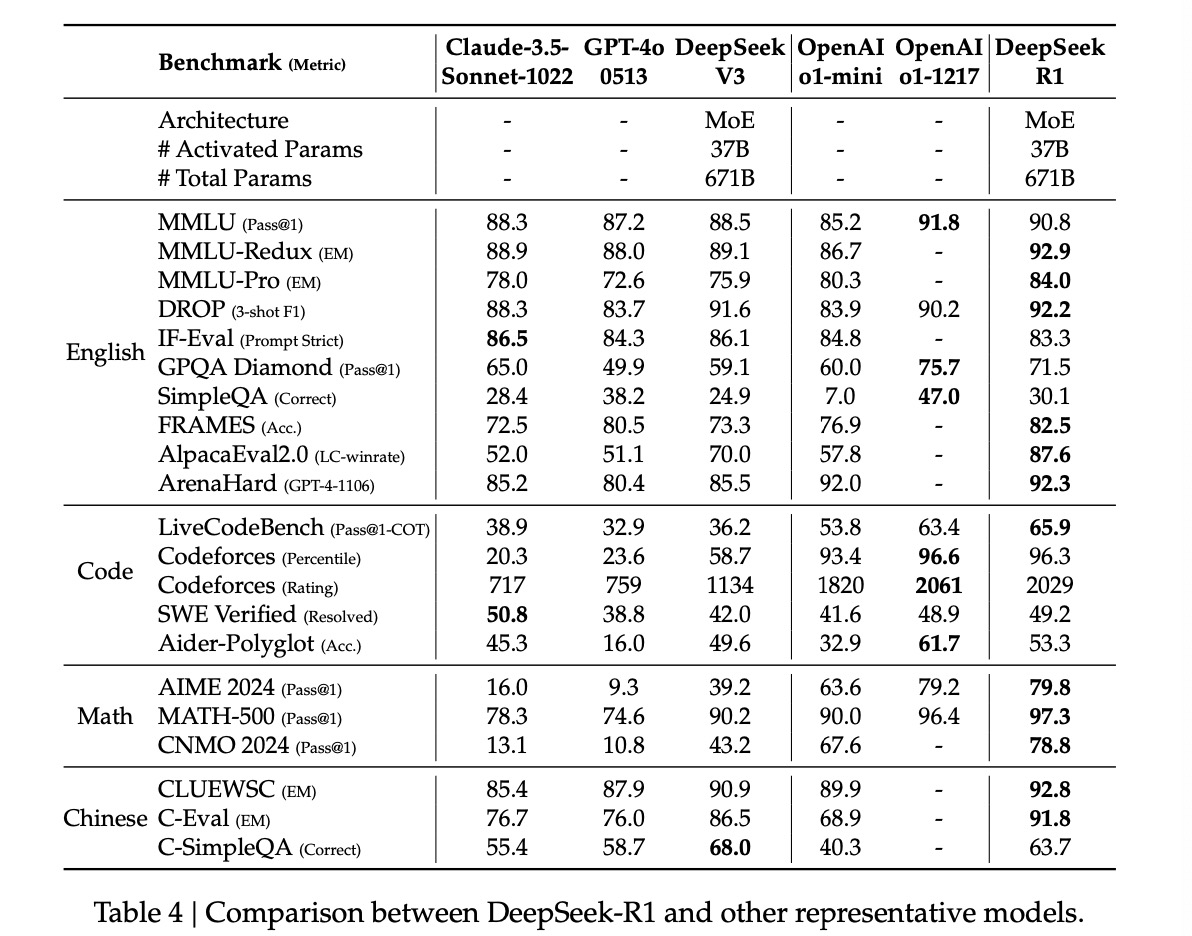

本次更新开源了DeepSeek-R1-Zero和DeepSeek-R1两个新旗舰reasoning模型,主要使用large-scale reinforcement learning且不需要SFT即完成训练,为开源社区给出了一个完全新颖且行之有效的reasoning LLM训练方案。其中DeepSeek-R1在reasoning任务上和OpenAI-o1-1217性能相当。除此之外,团队还开源了不同size的稠密模型(1.5B,7B,8B,14B,32B,70B),这些小模型是基于Qwen和Llama开源模型通过蒸馏DeepSeek-R1得到。

2. 主要贡献

新的后训练范式:在Base Model上直接使用Large-Scale RL

- 不使用SFT而直接基于base model做RL,让模型能够探索CoT来解决复杂问题。其中得到的DeepSeek-R1-Zero模型展现出了自我验证,反思,生成长的CoT的能力。

- 团队给出了DeepSeek-R1的详细训练pipeline,该pipeline包含两段RL阶段,分别用于提升reasoning能力和用于提升通用能力;以及包含两段SFT阶段,分别为模型获取reasoning和non-reasoning能力提供冷启动。

蒸馏:小模型也可以很强大

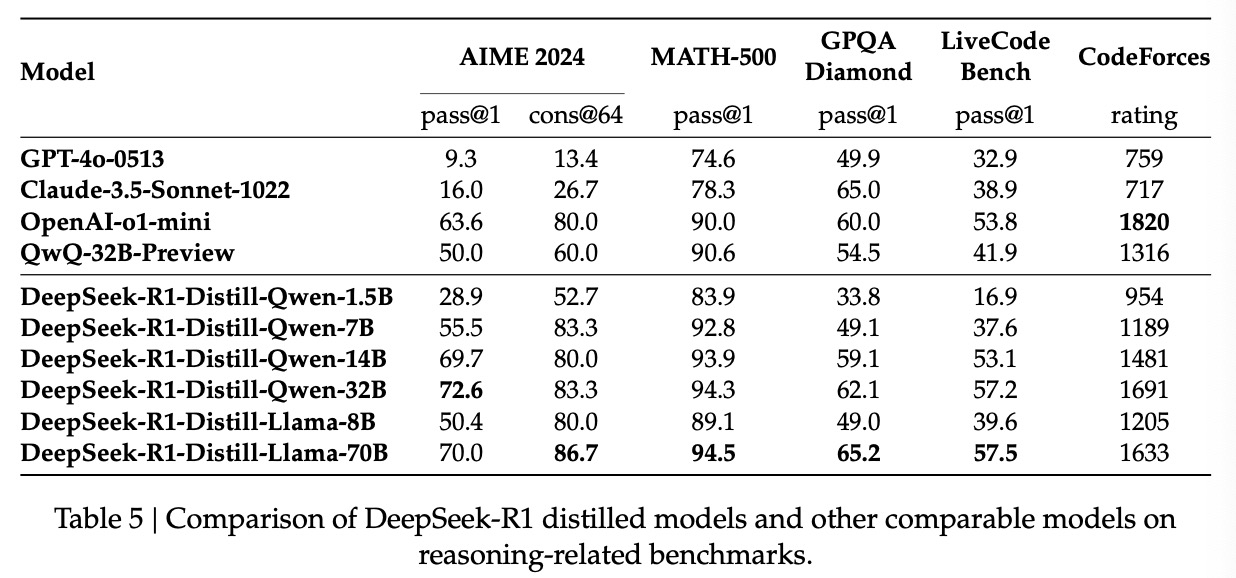

- 开源了多个size的基于Qwen2.5和Llama3系列模型使用DeepSeek-R1蒸馏得到的小模型,并且均在reasoning任务上展现了比同size最强开源模型更强的能力。在AIME2024、MATH-500、LiveCodeBench等基准上取得很高成绩。

3. 方法

3.1 DeepSeek-R1-Zero: Reinforcement Learning on the Base Model

DeepSeek-R1-Zero模型不实用任何有监督数据,不做SFT,仅使用纯粹的强化学习过程让模型自我进化。

3.1.1 Reinforcement Learning Algorithm

团队采用Croup Relative Policy Optimization(GRPO)强化学习算法。使critic model和policy model具有相同模型大小,具体来说,对每个问题$q$,GRPO从旧策略$\pi_{\theta_{old}}$采样一组输出${o_1,o_2,\cdots,o_G}$,然后使用如下优化目标优化策略模型$\pi_\theta$:

其中$\epsilon$和$\beta$为超参数,$A_i$为advantage,使用每个输出对应的奖励${r_1,r_2,\cdots,r_G}$计算得到。

3.1.2 Reward Modeling

团队没有用神经网络模型来获取奖励(主要防止在large-scale RL中的reward hacking问题,且增添训练pipeline复杂度),采用的是基于规则的奖励函数,主要包含以下两种规则:

Accuracy rewards:评估回答是否正确。例如,数学问题中,模型被要求提供某种格式下的最终答案;代码问题中,生成的代码能够被编译通过并基于预先准备的cases提供正确输出。

Format rewards:强制要求模型在其思考过程中打上‘<think>’和‘</think>’标签。

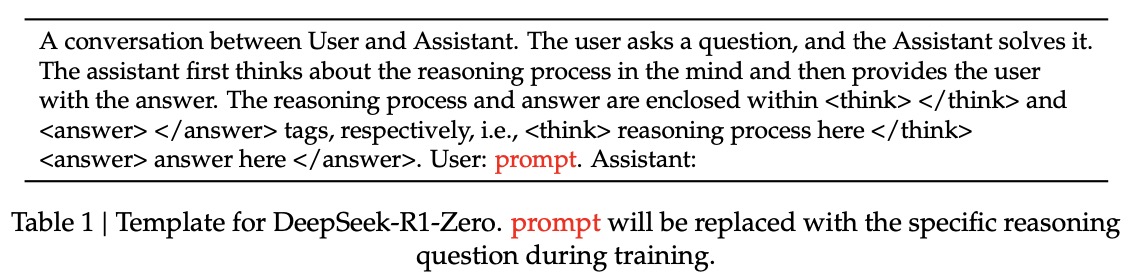

3.1.3 Training Template

DeepSeek-R1-Zero的训练模版如图1所示。该模版首先要求模型生成推理过程,然后是最终答案。

3.1.4 Performance, Self-evolution Process and Aha Moment of DeepSeek-R1-Zero

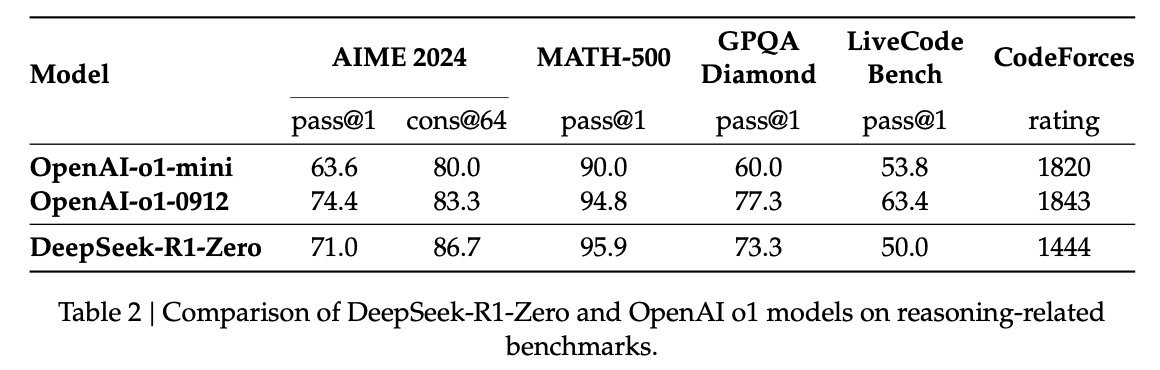

Performance

此外,团队发现通过majority voting,DeepSeek-R1-Zero的性能还能够进一步加强,在AIME上能从71.0%提升至86.7%。总结,DeepSeek-R1-Zero证明了不使用SFT而直接使用强化学习能够做到很优秀的推理能力。

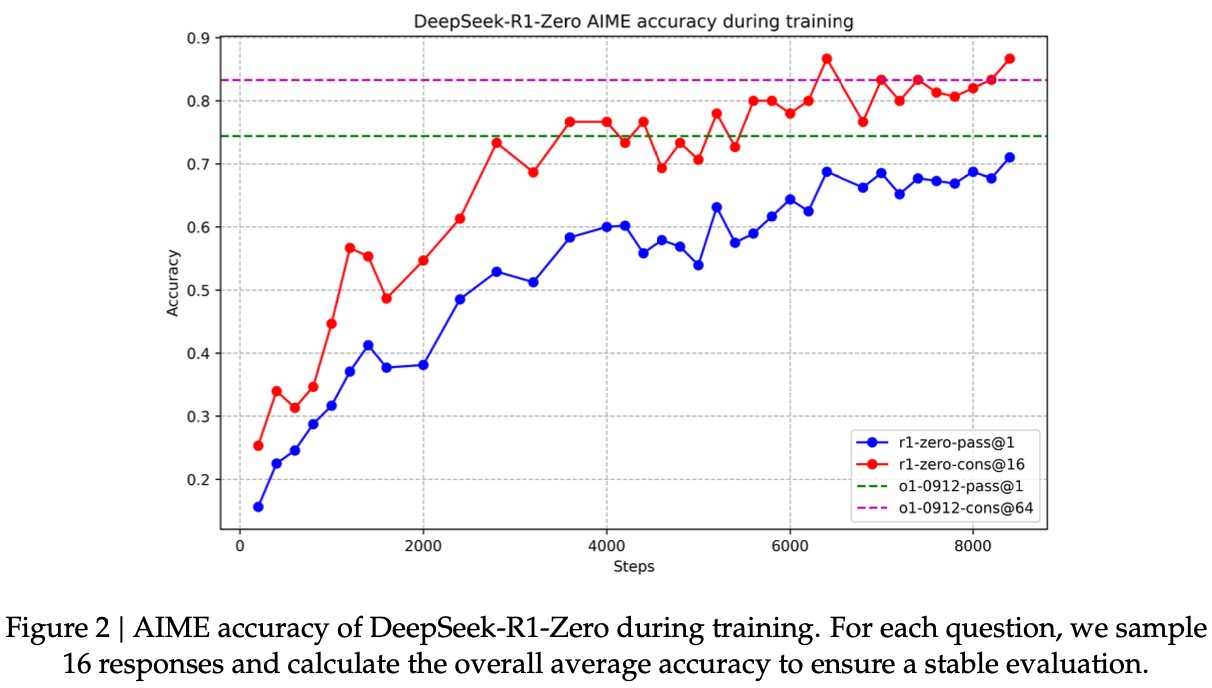

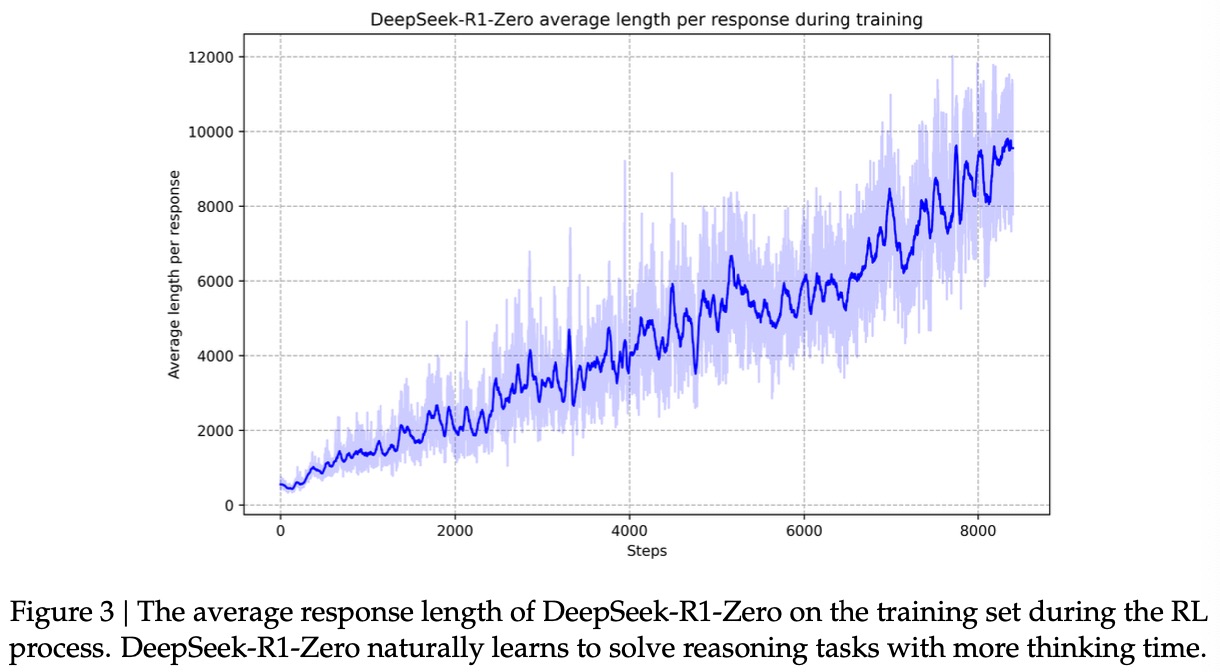

Self-evolution Process of DeepSeek-R1-Zero

团队发现随着RL训练步数的增加,模型生成长度不断提高,即表明模型回答问题时思考的时间越来越长,在这过程中模型出现了一些比较sophisticated的行为。比如reflection,模型会从新回看自己之前生成的内容;自发的探索其他可能的方法,这些能力并不是通过监督学习得到,而是通过RL训练过程中不断涌现出来的。

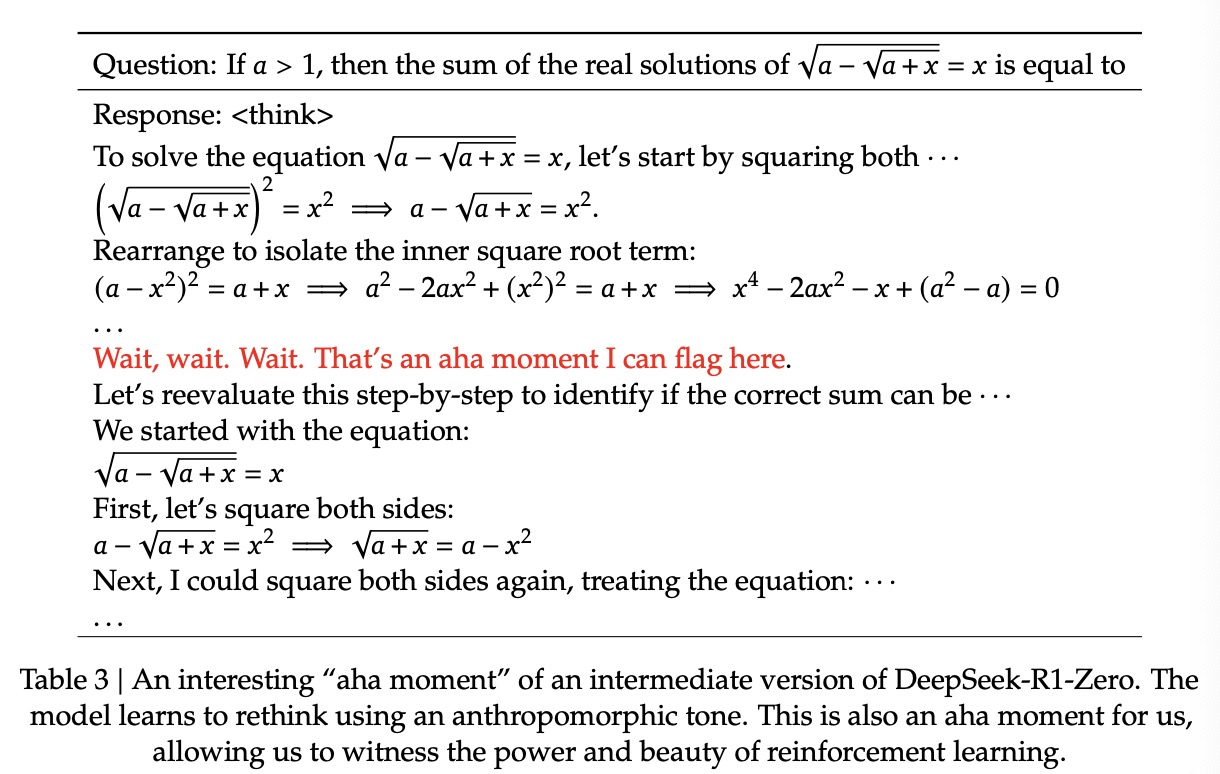

Aha Moment of DeepSeek-R1-Zero

这是在RL训练中间过程出现的一个case,即模型学会了通过重新评估自己先前给出的方案来为思考的过程支配更多的时间,这个case表明通过RL能够使模型导向更多超出预期的生成结果。

3.1.5 Drawback of DeepSeek-R1-Zero

DeepSeek-R1-Zero在阅读能力以及语言混合能力上有不足,对此,团队提供了DeepSeek-R1,使用human-friendly cold-start data并结合RL的方法训练出的模型。

3.2 DeepSeek-R1: Reinforcement Learning with Cold Start

受DeepSeek-R1-Zero强大推理能力的启发,团队提出两个新的问题:

- 通过加入一小部分高质量的数据作为冷启动之后,模型的推理能力能否进一步提升,或者模型收敛速度能否提快?

- 除了生成强大的CoT能力外,能否训练出一个user-friendly的,具有strong general capabilities的模型?

对此,团队设计了训练DeepSeek-R1的pipeline,包含下面四个阶段:

3.2.1 Cold Start

为了避免RL训练的初始不稳定的冷启动阶段,团队收集了一小批long CoT data(高质量SFT数据)用于微调base model作为initial RL actor,为了收集这样的数据,团队探索了几种方法:

- few-shot prompting with a long CoT as an example

- directly prompting models to generate detailed answers with reflection and verification

- 收集DeepSeek-R1-Zero的输出,做成可阅读模式,并通过人工精调这些输出

在该阶段,团队收集了几千条code-start data,并微调DeepSeek-V3-Base作为initial RL actor。相比于DeepSeek-R1-Zero,DeepSeek-R1添加了code-start data有以下几个好处:

- 增加输出可阅读性:DeepSeek-R1-Zero一个关键不足是输出的阅读性较差,回复中会混杂多个语言,且对关键部分缺少markdown高亮。

- 增加模型的潜力

3.2.2 Reasoning-oriented Reinforcement Learning

基于冷启动数据微调后的DeepSeek-V3-Base,团队使用DeepSeek-R1-Zero中相同的RL训练来训练DeepSeek-R1,这过程主要增强模型coding,mathematics,science,logic reasoning能力。

训练过程中团队发现模型输出的CoT经常混杂多个语言,尤其是当RL的prompt包含多种语言时。为了缓解该问题,团推引入了一种language consistency reward,用于衡量CoT中目标语言统一的比例。尽管消融实验表明添加这个reward会略微降低模型性能,但该reward能使模型输出更加的user-friendly。

3.2.3 Rejection Sampling and Supervised Fine-Tuning

当上一个阶段收敛后,团队使用收敛后的ckpt收集SFT数据(这次不像冷启动数据只针对reasoning,该阶段的SFT数据也包含其他领域,用于提升模型writing,role-playing,以及其他general-purpose任务的能力)

- Reasoning data:600k

- Non-Reasoning data:200k

3.2.4 Reinforcement Learning for all Scenarios

这一阶段主要为了强化模型除了reasoning外其他通用能力。该阶段中,奖励函数没有使用基于规则的,而是正常用reward model,采用DeepSeek-V3中RL的pipeline,并选择了相似分布的偏好数据对和prompt数据。

除此之外,该阶段还增强模型的helpfulness和harmlessness。

3.3 Distillation: Empower Small Models with Reasoning Capability

团队选了base model有:Qwen2.5-Math-1.5B,Qwen2.5-Math-7B,Qwen2.5-14B,Qwen2.5-32B,Llama-3.1-8B,Llama3.3-70B-Instruct。

对于蒸馏模型,团队仅使用SFT,没有RL阶段。其中SFT数据为3.2.3中使用DeepSeek-R1获取的800K条数据。

4. 实验

4.1 DeepSeek-R1 Evaluation

4.2 Distilled Model Evaluation

5. 讨论

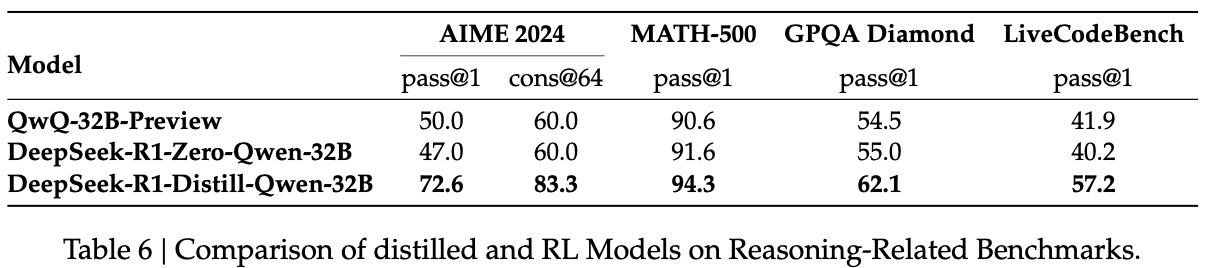

5.1 Distillation v.s. Reinforcement Learning

上图中,DeepSeek-R1-Zero-Qwen-32B是基于Qwen-32B-Base模型,使用math,code,STEM数据用large-scale RL训练超过10K步得到的,而DeepSeek-R1-Distill-Qwen-32B为基于Qwen-32B-Base模型使用DeepSeek-R1蒸馏得到。结果表明:

- 将大模型能力蒸馏到小模型上能表现出很好的效果,而小模型直接用large-scale RL不仅需要更多的算力,甚至也达不到蒸馏模型的效果。

- 尽管蒸馏方案经济且有效,扩充模型能力的边界仍需要基于更强的base models并使用larger-scale RL。

5.2 Unsuccessful Attempts

团队早期也尝试了Rrocess Reward Model(PRM)和Monte Carlo Tree Search(MCTS)等方案,但都失败了。

- Process Reward Model:PRM有三大主要限制

- 在一条推理链中精细定义一个step比较困难

- 判断当前中间step是否正确是一个充满挑战的任务。模型标注的数据并不能得到满意结果,而人工标注很难scaling up。

- 不可避免存在reward hacking的问题,重新训练奖励模型消耗大,增加整个训练流程的复杂度。

- Monte Carlo Tree Search:主要用于棋类RL算法

- 语言模型search space比棋类大得多,这样必须设定一个最大搜索限制,但这样会导致模型陷入局部最优。

- 价值模型直接影响生成质量,但训练一个好的价值模型很困难。

References

[1] DeepSeek-AI. “DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning ” arXiv preprint axXiv:2501.12948 (2025).